Im November 2022 hatte der Chatbot ChatGPT, der mit künstlicher Intelligenz arbeitet, seinen großen Durchbruch. Mit ihm wurde für viele erstmals erfahrbar, wozu künstliche Intelligenz in der Lage ist. Dass sie selbstständig Texte schreiben oder Bilder produzieren kann, ist erst der Anfang einer Entwicklung, die tiefgreifende Folgen für die Menschheit haben wird. KI bietet jede Menge Chancen - aber birgt auch eine Vielzahl von Risiken. Wird es gelingen, sie zu zähmen, einzuhegen, sie produktiv zu nutzen?

Der erste große Versuch, das zu tun, findet derzeit auf europäischer Ebene statt. Die Europäische Union will die Zukunft der Technologie mit dem Artificial Intelligence Act (AIA) in sichere Bahnen zu lenken. Am 13. März 2024 gab das EU-Parlament grünes Licht für das KI-Gesetz. In Brüssel gilt das Regelwerk als „historisch“. Die Hoffnung der EU-Länder ist, dass die Regeln weltweit Nachahmer finden.

Was sieht der AI Act der Europäischen Union vor?

Die Europäische Union ist mit dem Artificial Intelligence Act (AIA) derzeit weltweit Vorreiter bei der Regulierung von KI. Das KI-Gesetz geht auf einen Vorschlag der EU-Kommission aus dem Jahr 2021 zurück.

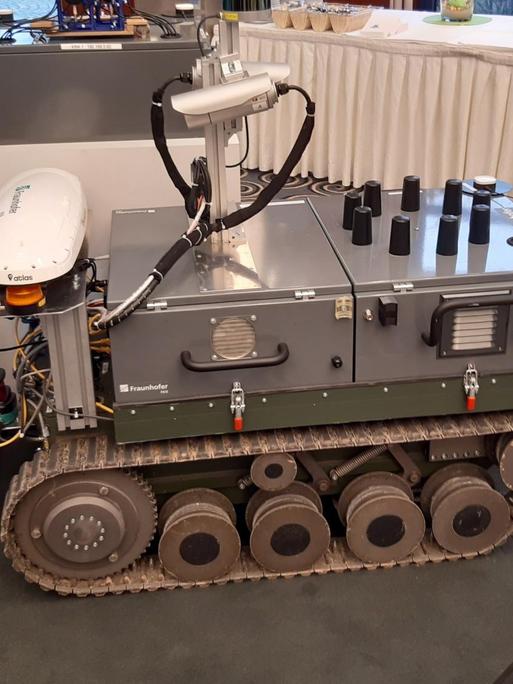

Der AI Act ordnet KI-Anwendungen in unterschiedliche Risikoklassen ein. Systeme, die als besonders risikoreich gelten und beispielsweise in kritischen Infrastrukturen oder im Bildungs- oder Gesundheitswesen eingesetzt werden, müssen strenge Anforderungen erfüllen.

Bestimmte KI-Anwendungen, die gegen EU-Werte verstoßen, sollen ganz verboten werden. Dazu gehören Programme, die Bürgerrechte einschränken, das menschliche Verhalten beeinflussen oder den freien Willen beschneiden - oder auch solche, die soziales Verhalten bewerten ("Social Scoring").

Gesichtserkennung im öffentlichen Raum

Auch die Gesichtserkennung im öffentlichen Raum - also zum Beispiel durch Videoüberwachung an öffentlichen Plätzen - soll grundsätzlich nicht erlaubt sein. Dabei gibt es jedoch Ausnahmen: Polizei und andere Sicherheitsbehörden sollen eine solche Gesichtserkennung im öffentlichen Raum nutzen dürfen, um bestimmte Straftaten wie Menschenhandel oder Terrorismus verfolgen zu können.

Biometrische Informationen dürfen nach dem AI Act nicht mit solchen über die politischen oder religiösen Anschauungen von Personen verbunden werden. Verboten ist es auch, am Arbeitsplatz Gesichter nach Gefühlen analysieren zu lassen. Entwickler müssen klar kenntlich machen, dass durch künstliche Intelligenz geschaffene Texte, Bilder und Töne auf dieser Technologie beruhen. Verstöße gegen die Regeln können mit hohen Geldstrafen geahndet werden.

Was sind die Gefahren von künstlicher Intelligenz?

Niemand weiß genau, wie gefährlich der Einsatz von KI potenziell ist. Doch sie wird zumindest von den meisten Expertinnen und Experten als grundsätzlich sehr mächtig eingeschätzt. Positive wie auch negative Auswirkungen könnten demnach immens sein.

Ende Mai 2023 beschrieben führende Experten die Gefahr durch KI in nur einem Satz: „Das Risiko einer Vernichtung durch KI zu verringern, sollte eine globale Priorität neben anderen Risiken gesellschaftlichen Ausmaßes sein, wie etwa Pandemien und Atomkrieg.“

Zu den Unterzeichnern der kurzen Stellungnahme gehörte auch OpenAI-Chef Sam Altman – jenes Unternehmens, das ChatGPT erfunden und damit den aktuellen KI-Hype maßgeblich ausgelöst hat. Die Stellungnahme wurde auf der Webseite des in San Francisco ansässigen Centers for AI Safety (Zentrum für KI-Sicherheit) publiziert.

Die Angst, die Kontrolle zu verlieren

Die Non-Profit-Organisation nennt als mögliche Gefahren von künstlicher Intelligenz ihren Einsatz in der Kriegsführung. Außerdem wird vor der Verbreitung von Falschinformationen sowie vor einer Zukunft gewarnt, in der die Menschheit komplett von Maschinen abhängig werden könnte.

Terrorismus, Waffenproduktion, Manipulation von Wahlen: Die Ängste vor dem missbräuchlichen Einsatz von KI sind groß. Hinzu kommt die Sorge, die Kontrolle über sie zu verlieren. Der KI-Experte Daniel Privitera warnt vor immer besseren und stärkeren KI-Modellen, die bereits teilweise selbstständig strategisch handelten und Menschen täuschen könnten.

Zugleich seien diese KI-Modelle „Blackboxes“: „Niemand versteht, was eigentlich in denen vor sich geht. Auch OpenAI selbst versteht das nicht. Wenn man so etwas nicht versteht, dann kann man es natürlich auch nicht verlässlich kontrollieren und steuern“, so Privitera.

"Ich finde auch die Idee beunruhigend, dass KI zum Beispiel unsere Gedanken lesen kann", sagt Alexandra Geese, Digitalexpertin der Grünen im Europaparlament. Es gebe bereits Technologie, die über Gehirnscans zeigen könne, "was wir uns vorgestellt haben, welche Bilder wir gesehen haben".

Ebenfalls sehr beunruhigend sei die potenzielle Auflösung der Realität, zum Beispiel durch Deepfakes. „Unsere Art und Weise zu prüfen, ob eine Information wahr oder nicht wahr ist, wird so kompliziert, dass sie eigentlich von normalen Menschen gar nicht mehr zu leisten ist", sagt Geese. Ergebnis wäre eine Welt, in der man zwischen Wahrheit und Lüge nicht mehr unterscheiden kann.

Welche weiteren Vorschläge gibt es, um KI zu regulieren?

OpenAI-Chef Sam Altman hat eine Aufsichtsbehörde nach dem Vorbild der Internationalen Atomenergiebehörde für die neue Technologie vorgeschlagen. Auch UN-Generalsekretär António Guterres spricht sich für die Einrichtung einer Regulierungsbehörde aus. Die G7 verständigten sich bei einem Gipfeltreffen in Japan darauf, eine gemeinsame Strategie zur Regulierung von KI in Angriff zu nehmen.

USA und EU diskutieren über einen freiwilligen KI-Verhaltenskodex. Die Entwickler künstlicher Intelligenz sollen zur freiwilligen Selbstkontrolle verpflichtet werden. Damit könne Zeit gewonnen werden, bis gesetzliche Regeln griffen, sagt die EU-Kommissarin für Digitales, Margrethe Vestager. Der AI Act der EU werde inklusive Übergangsfristen frühestens in zweieinhalb bis drei Jahren Wirkung entfalten. "Das ist offensichtlich zu spät. Wir müssen jetzt handeln."

„Der Geist ist aus der Flasche"

Der Digitalexperte Daniel Privitera sieht ebenfalls Eile geboten. Eine Lücke zwischen „dem Tempo des technologischen Fortschritts und unserer demokratisch legitimierten Kontrolle können wir uns nicht erlauben. Ich glaube, das kann wirklich katastrophal schieflaufen.“

„Der Geist ist aus der Flasche und lässt sich wahrscheinlich auch nicht mehr zurückdrängen“, sagt Ayad Al-Ani vom Berliner Einstein Center Digital Future. Er erwartet ein „Hochschaukeln“ von technologischem Fortschritt und seiner Einhegung durch gesetzliche Vorschriften: Neue KI-Anwendungen werden seiner Prognose zufolge Regulierungsversuche nach sich ziehen, die dann dazu führen, dass KI-Entwickler in andere Bereiche ausweichen, die dann ebenfalls nachreguliert werden müssen.

Die KI-Expertin Kenza Ait Si Abbou meint hingegen, dass es technisch durchaus möglich wäre, der KI den Stecker zu ziehen und einfach den Ausknopf zu drücken, sollte klar werden, dass die Risiken zu groß werden. Doch dafür müsse es dann auch einen weltweiten Konsens geben.

ahe, leg